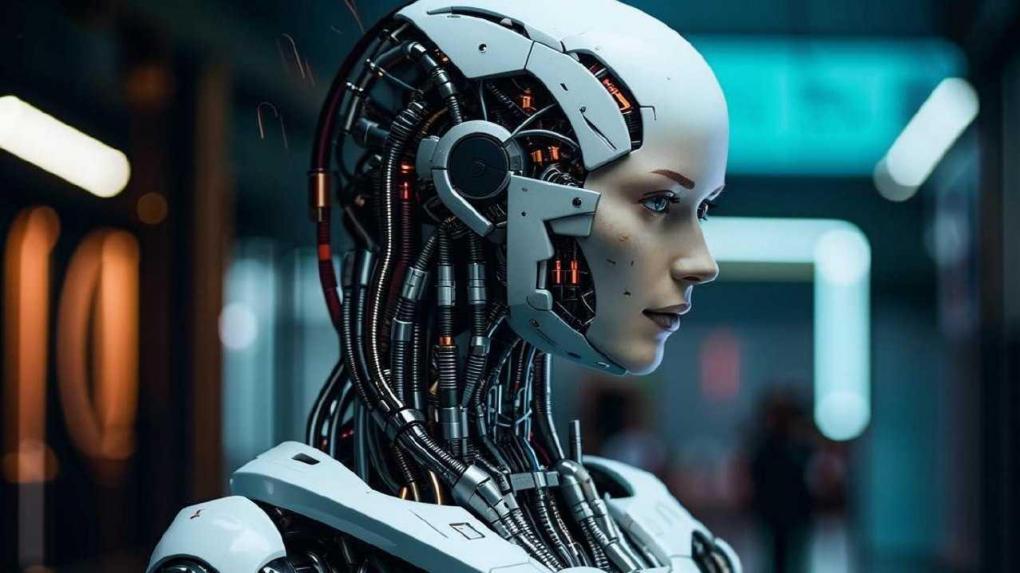

Резкий рост числа случаев мошенничества с использованием искусственного интеллекта вызывает обеспокоенность специалистов. Злоумышленники активно применяют технологии для создания дипфейков, подделывая фото, видео и даже голос в реальном времени, что делает атаки невероятно убедительными.

Среди новых опасных схем преступники имитируют звонки и видеосообщения от имени близких родственников, оказавшихся в беде. Однако наибольшую угрозу для организаций представляют атаки на сотрудников, когда мошенники, используя нейросети для клонирования голоса, выдают себя за руководителей. В таких случаях они в срочном порядке требуют перевести деньги на «безопасные» счета или передать конфиденциальные данные под предлогом решения неотложных служебных задач.

МЧС России призывает граждан и представителей бизнеса к повышенной бдительности. Ключевая рекомендация — никогда не доверять срочным просьбам о переводе средств или разглашении информации, поступившим через мессенджеры или по телефону, даже если звонок или сообщение кажутся абсолютно достоверными. Любые подобные распоряжения необходимо лично перепроверять, используя официальные и заранее известные каналы связи: корпоративную почту или прямой номер телефона, набранный самостоятельно, а не полученный из подозрительного сообщения. Также следует с осторожностью относиться к любым документам, фото и видео с эмблемами госорганов или изображениями публичных лиц в чатах, так как их теперь легко подделать.